Ada beberapa kondisi, dimana bot dari Search engine menyebabkan website kita menjadi lambat atau bahkan hingga down. Hal ini seringkali disebabkan karena proses crawl yang dilakukan oleh search engine terlalu banyak, sehingga menyebabkan load pada CPU atau resource di hosting. Untuk hal tersebut, salah satu solusi yang bisa kita lakukan adalah melakukan block bot search engine sementara waktu.

Seperti yang telah kita ketahui bersama, agar situs website kita dapat ditemukan orang lain di mesin pencari, maka website kita harus terindex lebih dulu. Proses indexing dilakukan oleh bot atau crawler mesin pencari pada website kita, untuk mencari teks dan tautan yang diperbarui. Apabila ditemukan, mesin pencari akan memperbarui index pencarian mereka.

Beberapa kasus, bot/spider jahat terlalu banyak merayap situs website, sehingga menghabiskan resource hosting atau server.

Hal ini dapat diatasi dengan memblok atau menghentikan bot search engine dengan file robots.txt, agar tidak merayapi situs website.

User-agents mesin pencari

Aturan paling umum yang digunakan dalam file robots.txt didasarkan pada User-agents dari perayap mesin pencari.

Perayap mesin pencari menggunakan User-agents untuk mengidentifikasi diri mereka saat merayapi website. Berikut beberapa contoh:

Top 3 User-agents mesin pencari US.

- Googlebot

- Yahoo!

- Slurp bingbot

User-agents paling umum diblok:

- AhrefsBot

- Baiduspider

- Ezooms

- MJ12bot

- YandexBot

Mengizinkan mesin pencari merayapi website

Berikut cara mengatur file robots.txt dengan dua aturan sederhana.

# Aturan pertama

User-agent: Googlebot

Disallow: /nogooglebot/# Aturan kedua

User-agent: *

Allow: /Keterangan:

- Aturan pertama, User-agents Googlebot (Google) bisa merayapi seluruh direktori, kecuali /nogooglebot/

- Atura kedua, semua User-agents (*) bisa merayapi seluruh direktori. Karena diallow (Allow: /)

- User-agents dapat Anda isi * (semua bot mesin pencari) atau diisi bot mesin pencari tertentu.

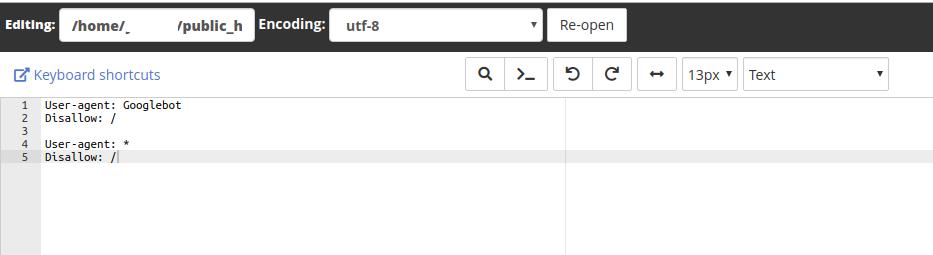

Block bot search engine merayapi website

User-agent: Googlebot

Disallow: /User-agent: *

Disallow: /Keterangan:

- User-agents: Googlebot tidak diizinkan merayapi seluruh direktori situs website.

- Semua User-agents tidak diizinkan merayapi seluruh direktori

Membuat file robots.txt dan memasangnya

- Buat file robots.txt didirektori website Anda.

- Masukan rule User-agents sesuai yang Anda butuhkan, kemudian simpan

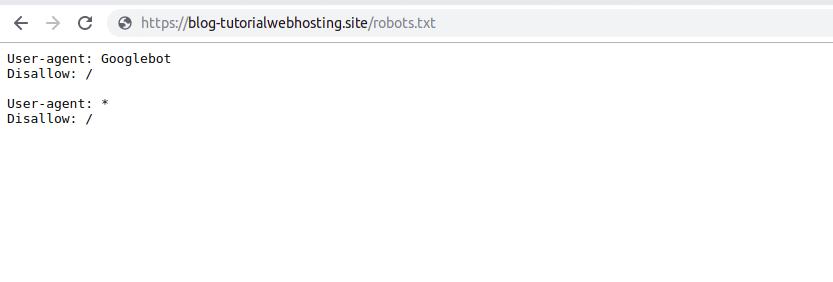

- Setelah itu, akses http://namawebsite/robots.txt . Apabila bisa tampi, berarti pemasangannya sudah berhasil.

Demikian cara menghentikan perayapan oleh mesin pencari, semoga bermanfaat.